Non ci saranno ulteriori versioni degli standard che hanno consentito la digitalizzazione delle trasmissioni tv nel mondo. Dopo il DVB-S2, DVB-T2 e DVB-C2 potrebbe nascere uno standard convergente, condiviso con le telco.

Il DVB World 2017 che si è tenuto quest’anno a Vienna rappresenta forse l’edizione più criptata degli ultimi anni, quella meno immediata da comprendere per via di un mercato in profonda trasformazione. Nelle edizioni precedenti, invece, la strada tracciata dagli standard adottati dal mercato consentiva di comprendere più facilmente le opportunità sicure.

Ora, però, un aspetto appare quasi certo: broadcaster e telco sembrano convinti che lo sviluppo di uno standard condiviso sia conveniente per entrambi, per preservare l’identità e consolidare i servizi che li hanno fatti diventare i riferimenti dei rispettivi mercati. Lo confermano gli utenti, ormai nativi ibridi, che chiedono di accedere ai contenuti dalle diverse piattaforme, da qualunque luogo, in ogni momento. Lo chiede, infine, l’industria che deve sfruttare le economie di scala per mantenere accessibile il costo della componentistica e del prodotto finito per assicurare il continuo sviluppo di tecnologie e mercati.

Abbiamo estratto alcuni argomenti caratteristici, dibattuti nell’arco dei tre giorni nei quali il DVB World si è sviluppato, per offrirvi alcuni spunti di riflessione e pensiero.

Legge di Moore al capolinea?

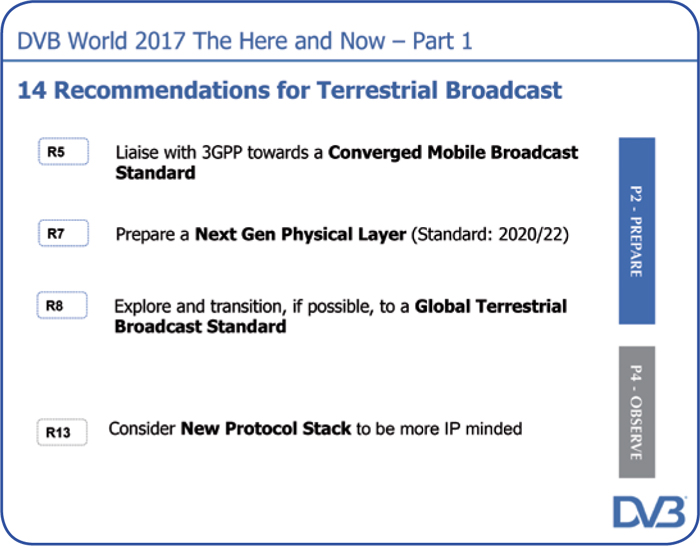

Le attività pianificate dal DVB per la televisione terrestre.

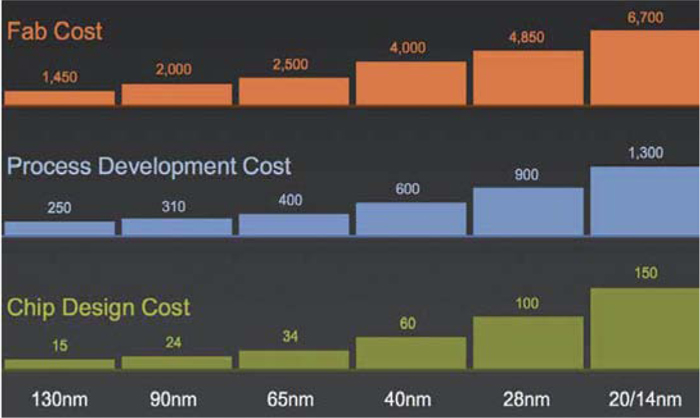

La comparazione dei costi per la fabbricazione, lo sviluppo dei processi e la progettazione dei chip, in funzione di un’integrazione sempre più spinta.

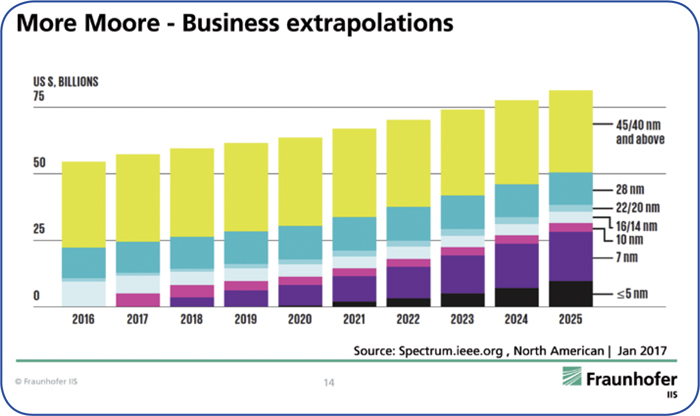

Le quote di mercato, in miliardi di dollari, in funzione del processo produttivo, espresso in nm. I valori in nm indicano la lunghezza del canale del componente base, il transistor CMOS.

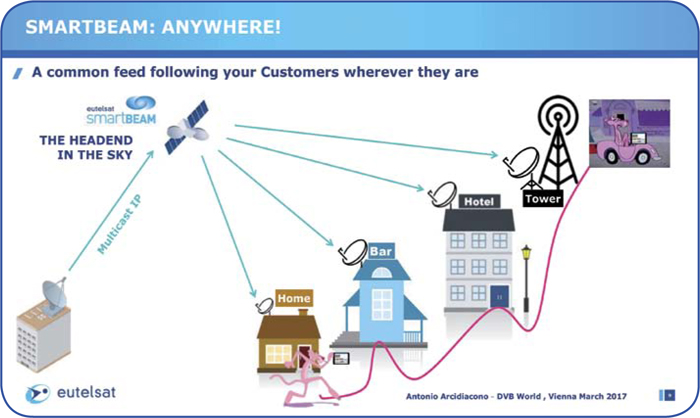

Antonio Arcidiacono, Direttore Innovazione di Eutelsat.

Nel 1965 Gordon Moore evidenziò un trend importante: nei sei precedenti anni il numero dei componenti elettronici che formavano un chip era raddoppiato ogni anno. Moore aveva appena fondato Intel, dopo essere diventato responsabile R&D di Fairchild Semiconductor. A lui si deve una legge che avrebbe descritto l’evoluzione dei microprocessori ben oltre gli anni 80: ogni 18/24 mesi il numero di semiconduttori presenti in un chip sarebbe raddoppiato grazie ad una sempre più spinta miniaturizzazione: così è accaduto. Ovviamente al raddoppio dei semiconduttori corrispondeva una crescita proporzionata della potenza di calcolo.

Successivamente a tale periodo la crescita della potenza di calcolo è stata mantenuta più o meno costante, anche con l’adozione di architetture evolute basate sul calcolo parallelo, per mantenere conveniente il costo di produzione dei chip, in crescita a causa dei costosi processi industriali necessari per sostenere una miniaturizzazione sempre più spinta.

Conviene miniaturizzare ancora?

Albert Heugerger, del Fraunhofer Institute, intervenuto al DVB World 2017, ha spiegato che la ITRS (International Technology Roadmap for Semiconductor ITRS) ha consentito negli anni il rispetto della legge di Moore attraverso un efficiente coordinamento comune di tutta l’industria che ha sviluppato nuove soluzioni tecnologiche ogni volta che incontrava un ostacolo. Nel 2014, però, la ITRS è stata riorganizzata tenendo conto che la legge di Moore poteva rallentare o, addirittura, fermarsi.

Sono state indicate due possibilità:

– Integrare due o più chip nello stesso package;

– Sviluppare più tipologie di processori, specializzati nelle diverse applicazioni.

Le tecnologie in prospettiva

Oggi, per produrre i chip è disponibile la tecnologia a 14 nm, mentre quella a 10 nm lo sarà a breve. I produttori stanno mettendo a punto un livello di integrazione ancora più spinto che prevede l’adozione della tecnologia a 7 nm, mentre sono in corso ricerche per raggiungere i 5 nm e andare oltre.

Secondo la maggior parte degli esperti del settore la barriera dei 7 nm e/o l’anno 2020 potrebbero rappresentare la decadenza della legge di Moore, nella sua forma corrente.

Fra i principali motivi, abbiamo i seguenti:

– l’integrazione sta raggiungendo i limiti fisici e gli effetti quantistici che iniziano a prevalere;

– la mascheratura per la produzione è sempre più complicata;

– le caratteristiche dei device diventano più critiche;

– la tensione operativa dei chip diminuisce e aumenta la varianza dei parametri circuitali;

– la complessità dello sviluppo si complica.

Dal punto di vista economico, l’integrazione a 28 nm inizia a mostrare criticità. Ad esempio, gli investimenti richiesti crescono in modo esponenziale, i benefici generati da una maggiore densità di componenti elettronici nei chip viene sfruttata appieno da un numero ridotto di prodotti (per il costo di produzione e di sviluppo), aumentano i rischi d’impresa.

Inoltre, la capacità di produrre componenti elettronici più piccoli da integrare nei chip non ridurrebbe necessariamente il costo dei chip.

I principali produttori di chip come Intel, TSMC, Samsung, GloablFoundries sono pronti a presentare chip da 10 nm e lavorano all’obiettivo successivo, per integrare a 7 nm, dove prevedono di incrementare i volumi di produzione grazie alle richieste in aumento relative a memorie, CPU per smartphone e tablet, CPU per server e desktop ad alte prestazioni, CPU/GPU per workstation grafiche, Realtà Virtuale, Intelligenza artificiale (comprese le applicazioni implementate nei veicoli a guida autonoma).

Le alternative

Resta il fatto che la maggior parte delle applicazioni, relative ai prodotti che fanno mercato utilizzano chip con fattori di integrazione da 45 a 28 nm, come accade per i decoder e i televisori, anche con risoluzione UltraHD-4K. Inoltre, la produzione a questi livelli di integrazione beneficerà di una riduzione dei costi, per l’ammortamento degli investimenti già effettuati. Per i processori d’immagine a risoluzione Ultra-8K così come per i decoder/TV potrebbero essere necessari chip da 14 nm.

In ogni caso, per un futuro di medio periodo, piuttosto che miniaturizzare ancora di più le dimensioni dei circuiti elettronici nei chip, appare probabile la possibilità di produrre chip che integrino nel package più circuiti integrati. Lo sviluppo di chip ‘specializzati’ rappresenta anch’essa una via di sviluppo, utile per produrre device performanti a costi contenuti.

SmartBEAM & SmartLNB

Il servizio SmartBEAM si rivolge ad una varietà eterogenea di target.

Il chip STiD337, per demodulare i segnali DVBS-S2/S2X, utilizzato nello SmartLNB, è stato sviluppato da STM.

I servizi resi possibili dallo SmartLNB per il mondo della televisione variano dal Video Multiscreen al Push VOD, dalle Transazioni alle Negoziazioni DRM, dalla Rilevazione dell’Audience alla Customer Intelligence e alla Diagnostica Remota.

Le due soluzioni riferite all’HDR, adottate dal DVB-UHD, fase 2.

L’intervento di Antonio Arcidiacono, Direttore Innovazione di Eutelsat, ha generato una particolare energia e ha ricordato che per ottenere una rinnovata fase di mercato positivo, capace di alimentare nuove installazioni che danno vita ad un fisiologico ricambio di mercato, è indispensabile rimettersi in gioco. Un atteggiamento che, sempre secondo Arcidiacono, abbiamo dimenticato un po’ tutti, dagli operatori all’industria; lo smalto degli anni novanta si è perso per strada. Non si investe più nelle nuove idee soprattutto per paura di sbagliare. Senza investimenti, però, il mercato non è in grado di riprendere slancio, ed è costretto a subire il corso degli eventi.

Le opportunità, ha ricordato Antonio Arcidiacono, ci sono. Il consumatore si è evoluto e bisogna sviluppare nuovi servizi. Eutelsat, al DVB World 2017, ha presentato una serie di servizi basati su DVB e IP. Si chiamano SmartBEAM e SmartLNB. Entrambi si basano sull’evoluzione della televisione satellitare, che diventa interattiva attraverso la piattaforma IP. Tre i benefici più importanti: primo, le pay tv satellitari possono offrire servizi IP a valore aggiunto, dialogare con i propri abbonati in tempo reale e distribuire contenuti IP; secondo, lo SmartLNB è una soluzione competitiva anche nell’M2M (Machine to Machine) e quindi nell’IoT, l’Internet delle Cose per la domotica; infine, con lo SmartBEAM si possono offrire servizi OTT via satellite.

Satellite & IP

Lo sviluppo delle reti in fibra ottica a banda larga, capaci di distribuire un numero elevato di programmi televisivi, pone l’interrogativo se questa infrastruttura di rete potrà diventare dominante nel prossimo futuro, nonostante non sia fisicamente in grado di raggiungere il 100% della popolazione e coprire il 100% del territorio. A questo, si aggiunge il fatto che oggi l’utente pretende che i contenuti debbano essere disponibili in qualsiasi momento e in qualunque area.

Per Eutelsat la risposta all’interrogativo è chiara e semplice: serve integrare più reti capaci di combinare i vantaggi della fibra ottica, della trasmissione satellitare e delle reti wireless per ottenere l’infrastruttura ideale, basata su DVB e IP. Per questo motivo Eutelsat ha sviluppato SmartBEAM, il broadcasting nativo in IP, da complementare con lo SmartLNB per una soluzione bidirezionale totalmente satellitare.

Come funziona l’interattività

La soluzione SmartLNB si basa su EBIS, Eutelsat Broadcast Interactive System, una rete IP composta da un hub, dal segmento satellitare e dai terminali interattivi.

Fornisce un canale IP bidirezionale a banda stretta che si aggiunge al normale servizio Direct-to-Home in banda Ku. Il canale di ritorno può essere in banda Ka o Ku. L’impianto di ricezione satellitare è composto da una parabola standard con lo SmartLNB che si collega all’unità IDU (In Door Unità) via cavo coassiale. L’unità IDU suddivide il TS video dal flusso IP. La soluzione SmartLNB si può implementare anche in impianti esistenti senza modificare il cablaggio, sfruttando i vantaggi tipici dell’Internet over Coax.

Smart LNB ODU 2,5

Per rendere possibile il servizio SmartLNB, Eutelsat ha coinvolto un produttore di chip, STMicroelectronics, e un produttore di LNB, la spagnola Egatel. Lo sviluppo dello SmartLNB ha dovuto soddisfare specifici criteri come il basso costo di produzione, anche in quantità limitate e la possibilità di variare ‘just in time’ le quantità da produrre in base alle richieste del mercato. Per ottenere questi risultati sono state implementate soluzioni tecnologiche che semplificano l’assemblaggio e la meccanica del prodotto. Le misure sono di 46x150x100 mm; si presta quindi ad essere montato anche affiancato ad un altro LNB, con una separazione di 4° fra le due posizioni orbitali.

Lo SmartLNB è bidirezionale: in ricezione utilizza la banda tradizionale da 10,70 a 12,75 MHz mentre in trasmissione occupa la banda da 13,75 a 14,5 GHz, con una potenza massima di 27 dBm.

DVB UHD, fase 2

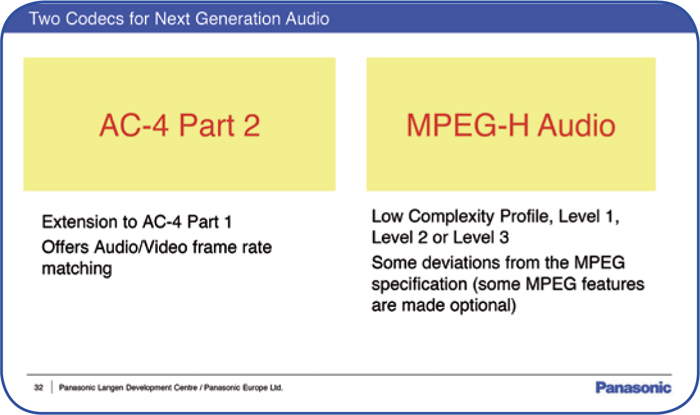

I due codec previsti per la NGA, Next Generation Audio.

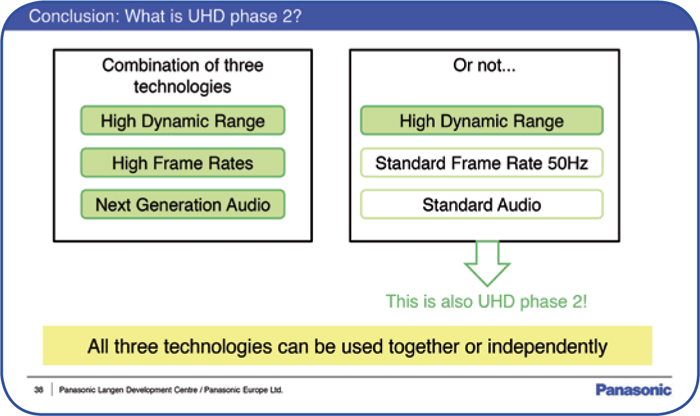

La fase 2 prevede di adottare tre diverse tecnologie: HDR, HFR e NGA.

Pochi giorni prima che iniziasse il DVB World 2017, l’ETSI, ha reso note le specifiche DVB UHD fase 2 (audio e video) per contenuti televisivi.

Alla conferenza si è parlato quindi della fase 2, disponibile per la fine del 2017, necessaria per gestire l’implementazione delle tecnologie che la differenziano dalla fase 1, come HDR, HFR e NGA. L’obiettivo principale è mantenere la compatibilità con la fase 1; fra gli aspetti più importanti le due soluzioni HDR proposte al mercato: Dolby Vision, non retrocompatibile, PQ più metadati opzionali e HLG10, sviluppato da BBC e NHK, retro-compatibile.

Si è discusso anche di alcuni test sul campo effettuati per valutare sul telespettatore l’impatto di determinate soluzioni, ad esempio: la percezione della migliore qualità di un segnale UHD a 60, 120 oppure 240 Hz.

I risultati confermano che quando le prestazioni diventano più sofisticate il target in grado di apprezzarle assume le dimensioni di una nicchia. Così capita, ad esempio, che un HFR da 120 Hz viene giudicato significativamente migliore rispetto ai 60 Hz ma, in proporzione, non altrettanto migliore dei 240 Hz.

La TV tradizionale è finita?

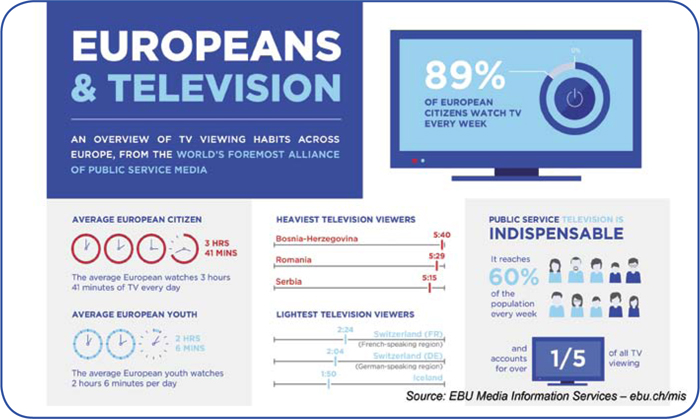

I consumi televisivi dei telespettatori europei: 3,41 ore in media, 186 minuti per i più giovani, l’89% guarda la TV almeno una volta la settimana.

L’intervento di Angelo Pettazzi al DVB World 2017.

L’intervento di Roberto Suárez Candel, EBU, anche attraverso il commento dei dati della ricerca ‘Media Consumption Trend 2016’, ha contribuito a svelare i falsi miti che si aggirano fra gli addetti ai lavori e non solo. Uno di questi è la fine della tv tradizionale (lineare).

In realtà, non è proprio così: è vero che le persone, rispetto al passato, dedicano molto più tempo ai mezzi di comunicazione e, soprattutto, cresce il consumo online (+15%), ma la quantità di ore trascorse davanti al televisore in Europa si mantiene pressoché stabile (-2%), dominata dai programmi in diretta che superano, anche fra i giovani, il 50% del tempo totale. Un altro dato che conferma la forza della televisione tradizionale sono i dati sull’intenzione di abbandonare a breve la televisione lineare, variabili dal 2% (dai 16 a 64 anni) al 4% (da16 ai 24 anni).

Aggiungiamo che i telespettatori della televisione online (il dato è riferito agli abbonati di Netflix) dedicano 90 minuti al giorno alla visione online e ben 172 minuti a quella lineare. Quindi, anche chi è attratto dai contenuti online è altrettanto coinvolto dalla TV tradizionale. Infine, da sottolineare quali device vengono utilizzati per guardare i programmi TV: la classica televisione mantiene una quota di mercato ben al di sopra del 90%. Per riassumere: ogni giorno passiamo più tempo a guardare contenuti video perché si sono moltiplicati i device che ce lo permettono di fare, ma la televisione tradizionale e il classico televisore mantengono identità e funzioni di sempre.

Un’ultima riflessione, importante per valutare con equilibrio i dati riferiti al consumo dei contenuti: il mondo internet è solito valutare il consumo di un video in base a quante visualizzazioni ha prodotto; quello televisivo tradizionale, invece, riferisce al tempo trascorso davanti al televisore nell’unità di tempo (giorno, settimana, mese, anno). Questi due metodi non sono omogenei fra loro e quindi non comparabili. Se il consumo della televisione online adottasse come metro di misura il tempo dedicato alla visione, allora i dati cambierebbero di significato.

Il mercato HBB in Italia

Abitazioni e piattaforme di comunicazione.

David Wood, EBU, Chair DVB CM-VR Study Mission.

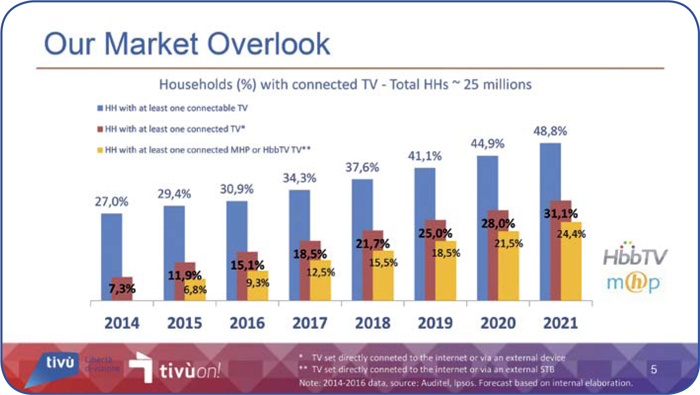

L’intervento di Angelo Pettazzi, che alla conferenza rappresentava Tivù, ha focalizzato la situazione nelle abitazioni italiane riguardo al numero di televisori/decoder collegati a internet, alla luce del nuovo standard interattivo HbbTV 2.0 che subentrerà all’MHP nei nuovi televisori/decoder terrestri dalla fine del 2017.

Oggi il mercato italiano, composto da circa 25 milioni di abitazioni, è formato da circa il 28% di appartamenti dotati di ricezione satellitare, il 77% con collegamento a internet, il 42% con internet broadband e il 15% dotati di televisori collegati a internet. La penetrazione satellitare è stabile, quella internet crescerà e le abitazioni con un televisore collegato a internet entro il 2021 raddoppieranno.

Le abitazioni dotate di un televisore con un collegamento a internet cresceranno dal 34% circa di quest’anno a quasi il 49% del 2021, così come le abitazioni che avranno almeno un televisore connesso in rete dal 18% circa passeranno al 31%. Oltre i 2/3 dei televisori/decoder avranno a bordo l’MHP o il nuovo HbbTV: dagli oltre 3 milioni di oggi si passerà agli oltre 6 milioni del 2021.

La nuova versione HbbTV 2.0, inoltre, consentirà di aggiungere messaggi pubblicitari anche personalizzati, gestire lo schermo secondario e multiscreen in sincro. I broadcaster potranno monitorare, anche in tempo reale il consumo dei dati, profilare gli utenti e riservare loro campagne ad hoc.

Oltre l’HEVC, il nuovo codec

Abitazioni con televisori collegati in rete, con MHP o HbbTV.

La nuova generazione del codec video è già in fase di sviluppo. Come si sa, da quando un nuovo codec viene reso disponibile all’industria passano circa 12/24 mesi per avere disponibili i chip e i device compatibili; invece, bisogna aspettare una decina d’anni per vedere il codec successivo, il tempo che serve per raddoppiare le prestazioni di compressione.

L’HEVC è stato approvato nel 2013 e durante il 2014 sono apparsi device compatibili, quindi è lecito aspettarsi entro il 2023 una nuova generazione, in fase di sviluppo. I tempi, però potrebbero accorciarsi perché il consumo di banda richiesta dai nuovi standard tecnologici esige algoritmi di compressione più efficienti; per questo motivo, forse, entro la fine del 2020 il nuovo codec potrebbe essere disponibile. Lo sviluppo è in corso e si è già raggiunto un risparmio di banda intorno al 30% rispetto all’HEVC ma è probabile che al termine del percorso si possa raddoppiare la quantità di dati a parità di banda di frequenza.

Fra le evoluzioni tecnologiche prese in considerazione abbiamo le seguenti:

– applicazioni 5G, sensori video ubiqui;

– streaming UHD di massa;

– HDR e WCG (Wide Colour Gamut) come riferimenti primari;

– Realtà Virtuale e Realtà Aumentata, punto di visione libero, ecc.

Masterclass: Realtà Virtuale

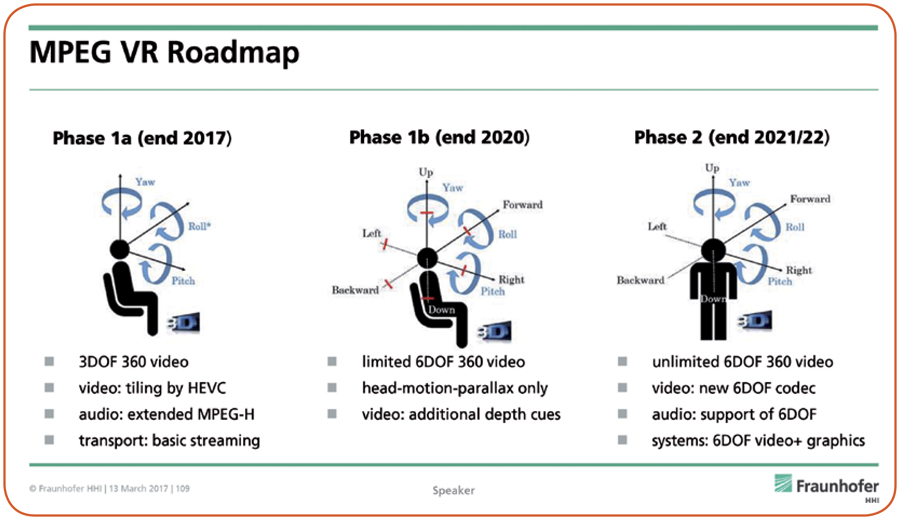

Il percorso individuato dal consorzio MPEG per lo sviluppo della Realtà Virtuale prevede ter step: 2017, 2020 e 2021/22.

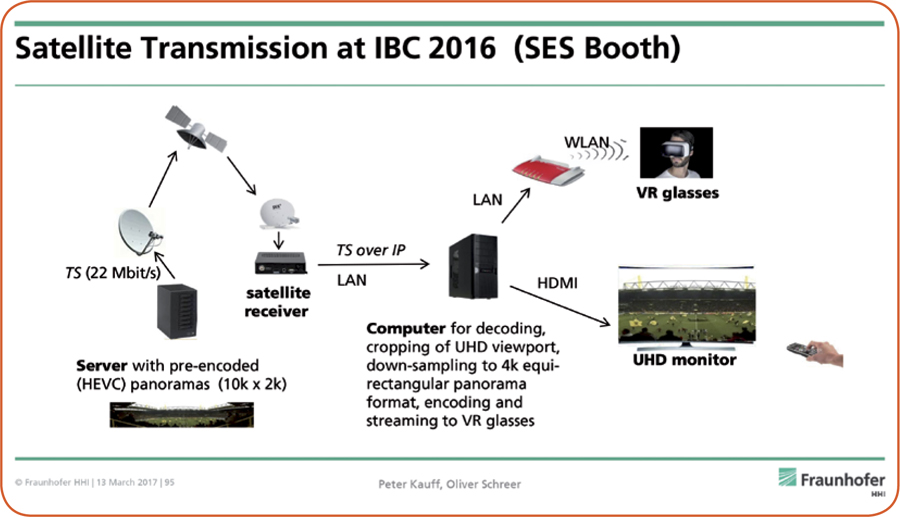

La configurazione della trasmissione organizzata da SES via satellite durante IBC 2016.

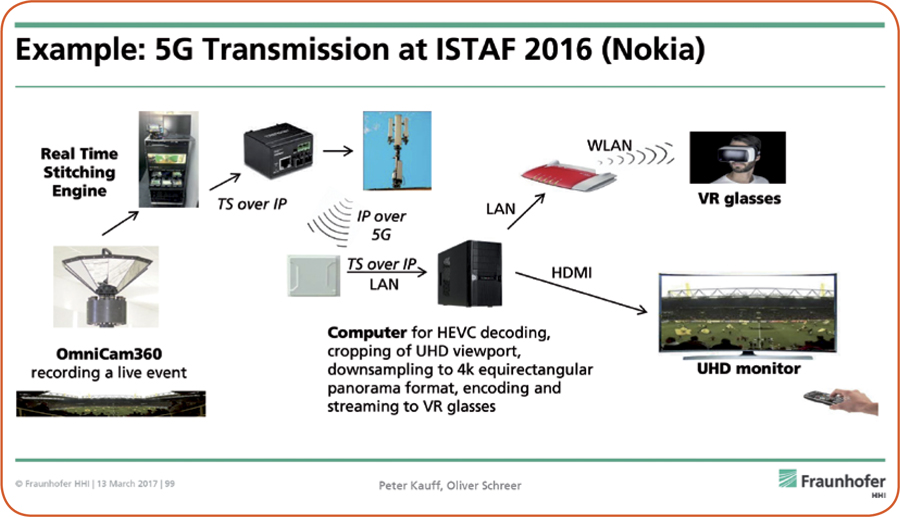

La configurazione della trasmissione organizzata da Nokia via 5G durante ISTAF 2016.

Alcuni esempi di dispositivi specifici per rappresentare la Realtà Virtuale.

Masterclass è una sessione formativa che, tradizionalmente, si tiene la mattina e anticipa l’avvio del DVB World.

Ogni anno viene scelto un tema importante per le possibili prospettive di mercato, sul quale è necessario un approfondimento propedeutico, soprattutto per chi è a digiuno della materia. Si descrive lo stato dell’arte, con una breve introduzione storica, gli aspetti da sviluppare e le possibili applicazioni.

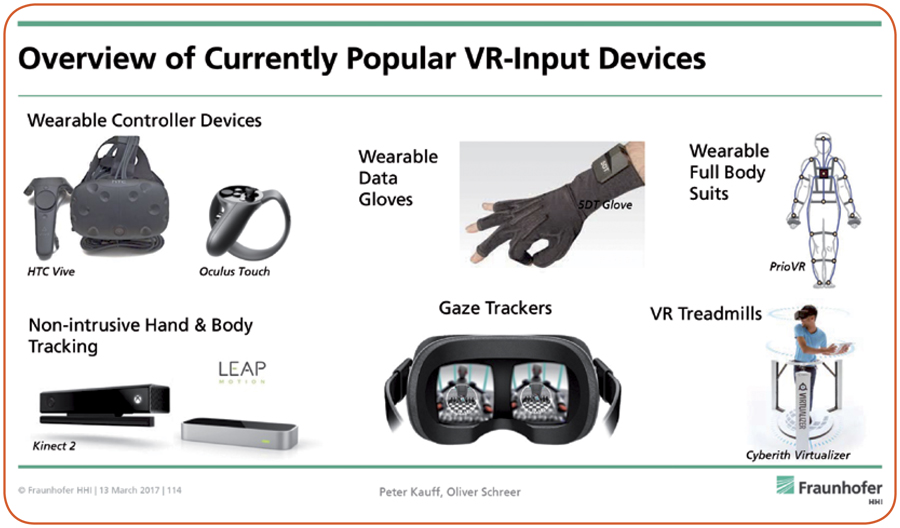

Quest’anno l’argomento scelto è stato la Realtà Virtuale. Con la realtà virtuale sono stati approfonditi anche aspetti legati a produzioni video a 360°. La sessione articolata in tre ore è stata tenuta da Peter Kauff e Oliver Schreer, che lavorano al dipartimento tecnologie Vision & Imaging del Fraunhofer Heinrich Hertz Institute.

Le origini

Le apparecchiature sviluppate per applicazioni di realtà virtuale risalgono ai primi decenni del secolo scorso, ad esempio con il simulatore di volo Link Trainer messo a punto nel 1929. Ci sono altri numerosi esempi, come il Sensorama del 1950 o la Roaming Caterpillar degli anni ’80. Anche i video a 360° hanno una lunga storia alle spalle: il Cineorama risale addirittura al 1897 e fu presentato all’Expo di Parigi nel 1900.

Tornando alla realtà di tutti i giorni, ormai da diversi decenni l’industria ha sviluppato device più o meno sofisticati per sedurre il consumatore finale con la realtà virtuale, una visione dei contenuti video non proprio naturale ma, certamente, curiosa e attraente.

Nelle applicazioni professionali di nicchia, invece, la realtà virtuale è ormai uno strumento di formazione consolidato, Basti pensare soltanto ai simulatori di volo/auto o i sistemi utilizzati per l’addestramento dei piloti.

Il trend

Negli ultimi anni gli investimenti in ambito consumer sono stati rilevanti: basti pensare soltanto ai 2 miliardi di dollari spesi da Facebook per il suo Oculus.

Il 2016 viene considerato l’anno zero per iniziare a calcolare la penetrazione del mercato di questi dispositivi; nel 2020, così dicono le previsioni, si potrebbe assistere ad un mercato sostenuto da investitori sparsi un po’ in tutto il mondo, suddivisi nei mercati mobile, console videogame e PC. L’attenzione a questo genere di applicazioni video è molto elevata: sia l’industria di riferimento che i broadcaster e i telecom operator stanno effettuando prove e verifiche per valutare la produzione di contenuti di realtà virtuale da proporre al proprio parco clienti. Anche le ricerche di mercato iniziano a dedicarsi alla realtà virtuale: fra i contenuti in cima ai desideri degli utenti abbiamo i viaggi virtuali, i concerti musicali virtuali, il volo virtuale, l’immersione in acqua virtuale, ecc. Contenuti che gli spettatori vorrebbero ‘vedere’ dai broadcaster tradizionali, molto più che dai servizi on-demand o i social media.

Le due categorie di mercato

Sono due le principali categorie di realtà virtuale:

– video a 360°

– video volumetrici

La prima utilizza smartphone, applicazioni wireless mobili, hardware dedicati, visori 2D o 3D, con tre gradi di libertà.

La realtà virtuale volumetrica, invece, si realizza con pc, console e desktop per visualizzare immagini 3D di sintesi. A differenza dei video a 360°, grazie alla disponibilità dei 6 gradi di libertà con il video volumetrico è possibile immergersi nella scena per viverla, come fosse reale.

I video a 360° vengono girati utilizzando apparecchiature composte da array di telecamere, ciascuna dedicata ad uno spicchio dell’angolo a 360° oggetto della ripresa.

Assistendo ad un video a 360° la prima cosa che si nota è la scarsa qualità delle immagini, dovuta alla bassa risoluzione dei visori indossati, di per sé ad alta qualità ma inadatti ad applicazioni di questo tipo. Per capire quale risoluzione devono offrire questi visori, affinché l’immagine visualizzata venga percepita come reale, si deve ricorrere alla valutazione dell’acutezza dell’occhio umano, capace di distinguere i dettagli di un oggetto. Tradotto in pixel, significa accedere ad una risoluzione pari a 22k x 11k per un video panoramico a 360°, equivalente ad una risoluzione di 8k per singolo occhio (utilizzando un visore a due display, ciascuno dedicato ad un occhio). E’ evidente, quindi, la bassa qualità percepita, dovuta al fatto che siamo ancora ben lontani da queste prestazioni.

Audio immersivo

L’audio immersivo è il perfetto complemento al video a 360°. Se l’obiettivo è far sentire al centro della scena lo spettatore, diventa indispensabile creare una riproduzione audio altrettanto realistica. Al tal proposito la qualità dell’audio immersivo disponibile già ora è davvero elevata perché sfrutta l’evoluzione e l’esperienza maturata in decenni di lavoro per lo sviluppo dei sistemi home theater e delle sale cinema commerciali. E’ la qualità video ancora da perfezionare e ci vorranno parecchi anni per ottenere un livello soddisfacente.

Disturbi correlati alla visione

Così come la visione di immagini televisive e cinematografiche 3D, anche quelle riferite alla realtà virtuale possono generare disagi evidenti, veri e proprio disturbi psico-fisici capaci di generare nausa e perdita di equilibrio, conosciuti anche come cybernausa o cinetosi (nausa da movimento). Nello specifico, sono stati condotti studi su pazienti volontari che hanno determinato quattro categorie di sintomi esperienziali:

– problemi generici, disagio;

– problemi agli occhi;

– perdita di orientamento;

– nausa.

Questi sintomi sono dovuti ai seguenti elementi:

– tremolio delle immagini;

– frequenza di refresh troppo bassa;

– ampiezza del visore, deve aumentare per migliorare la sensibilità periferica;

– la visualizzazione delle immagini deve avere un ritardo massimo di 300 ms, altrimenti l’utente dissocia il proprio movimento all’interno della scena.

– I disturbi avvertiti dagli utenti sono proporzionali al tempo di fruizione.

Altri fattori, da considerare altrettanto importanti, sono riferiti ad aspetti genetici (ad esempio, i cinesi sono più sensibili alla nausea da movimento), di genere (le donne manifestano maggiori sintomi causati dalla nausea da movimento) o di età (fino a 6/7 anni i bambini sono immuni da queste problematiche, il picco viene raggiunto intorno a 9/10 anni, quindi decresce fino a 20 anni e poi si stabilizza).